高中 自慰 计较机领域最高奖为何颁发给强化学习前驱?一文读懂强化学习

发布日期:2025-04-04 22:45 点击次数:126

2025年3月高中 自慰,计较机科学最高荣誉图灵奖颁发给强化学习前驱Richard Sutton和Andrew Barto。他们的表面曾被视为“实验室玩物”,如今却营救着ChatGPT的对话质料优化、DeepSeek的代码生成,甚而让机器东谈主学会后空翻。这项期间究竟怎样让机器像东谈主类一样“在跌倒中成长”?让咱们抛开专科术语,揭开它的中枢逻辑。

智能的底层逻辑:三个重要拼图想象教孩子骑自行车:他先歪七扭八地蹬踏板(尝试行为),颠仆时膝盖擦伤(负面响应),更动要点后终于保持均衡(优化计策)。强化学习的本色恰是这种“尝试-响应-纠正”的轮回,但背后荫藏着三个精密联想:

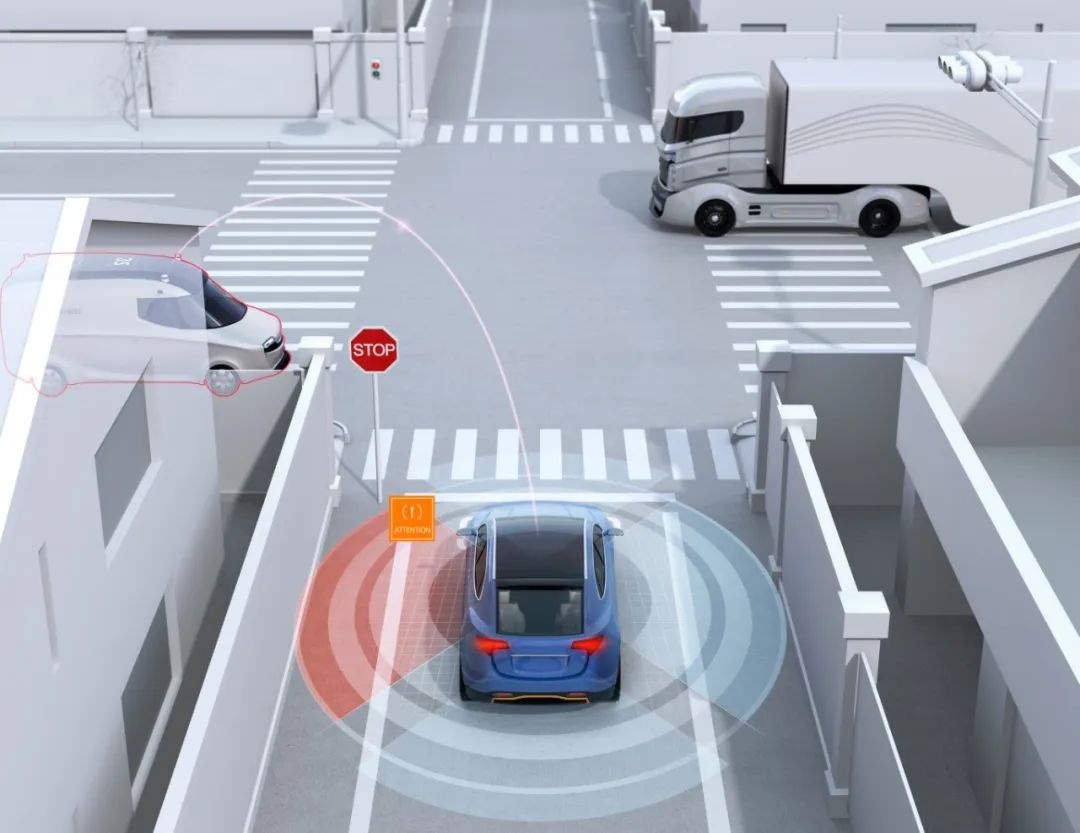

环境感知的“雷达系统”

智能体通过传感器(如录像头)或数据接口(如网页点击记载)感知“情状”——可能是围棋棋盘布局、聊天对话历史,或是机器东谈主重要角度。重要联想在于:现时情状必须包含有缱绻所需的一齐信息。就像司机无需回忆昔时一小时的路况,只需字据此刻导航图判断是否变谈。

奖励信号的“指挥棒”

联想者通过数值奖励指点学习标的:AlphaGo告成得+1分,失败-1分;电商保举系统字据点击率计较收益。但着实的灵敏体面前延长奖励的传递。举例围棋中,某步棋的赢输影响可能在20步后才流露,算法需要修复“蝴蝶效应”的因果链。

计策优化的“进化论”

智能体领先像没头苍蝇般立时尝试,但当某个行为带来高奖励(如游戏得分增多),算法会渐渐教训该行为的收受概率。这访佛生物进化:能适合环境的基因被保留,不适合的被淘汰。深度学习的加入让这个流程加快——神经集结能从海量尝试中详细出“哪些特征组合容易成效”的规章。

破解“鱼与熊掌”清苦:

探索与愚弄的均衡术

假定你每天收受午餐餐馆:熟悉的店口味肃肃(愚弄已知信息),但新开的店可能有惊喜(探索未知)。强化学习濒临一样的抉择:

峭壁边的严慎:仿真测试流程中,自动驾驶算法在99%时辰里安全行驶(愚弄老到计策),但会偶尔试探性变谈以发现更优道路(探索可能性)。

意思心运转:DeepMind劝诱的Agent会主动围聚迷宫中的未知区域,这种“肄业欲”通过内在奖励机制兑现——系统会给未充分探索的情状稀疏加分。

这种均衡通过“软性计策”兑现:初期饱读吹多半立时尝试(如儿童庸碌战役各式事物),后期徐徐拘谨到高收益行为(如成东谈主酿成肃肃行径模式)。在ChatGPT的老师中,这种机制体现为:早期生成天马行空的回答以探索讲话可能性,后期锁定稳当东谈主类偏好的抒发方法。

从围棋到对话:

深度强化学习的“跨界转换”

2016年AlphaGo投诚李世石,初次向全球展示了强化学习的威力。但更久了的变革发生在期间底层:

神经集结的“翻译官”变装

传统算法需要东谈主工界说“棋盘上风”“对话质料”等特征,而深度学习能顺利从原始数据(如像素、笔墨)中索要详细主张。举例DeepSeek处理代码生成任务时,神经集结结自动识别“变量定名表率性”“逻辑结构复杂度”等要领员未尝显式标注的特征。

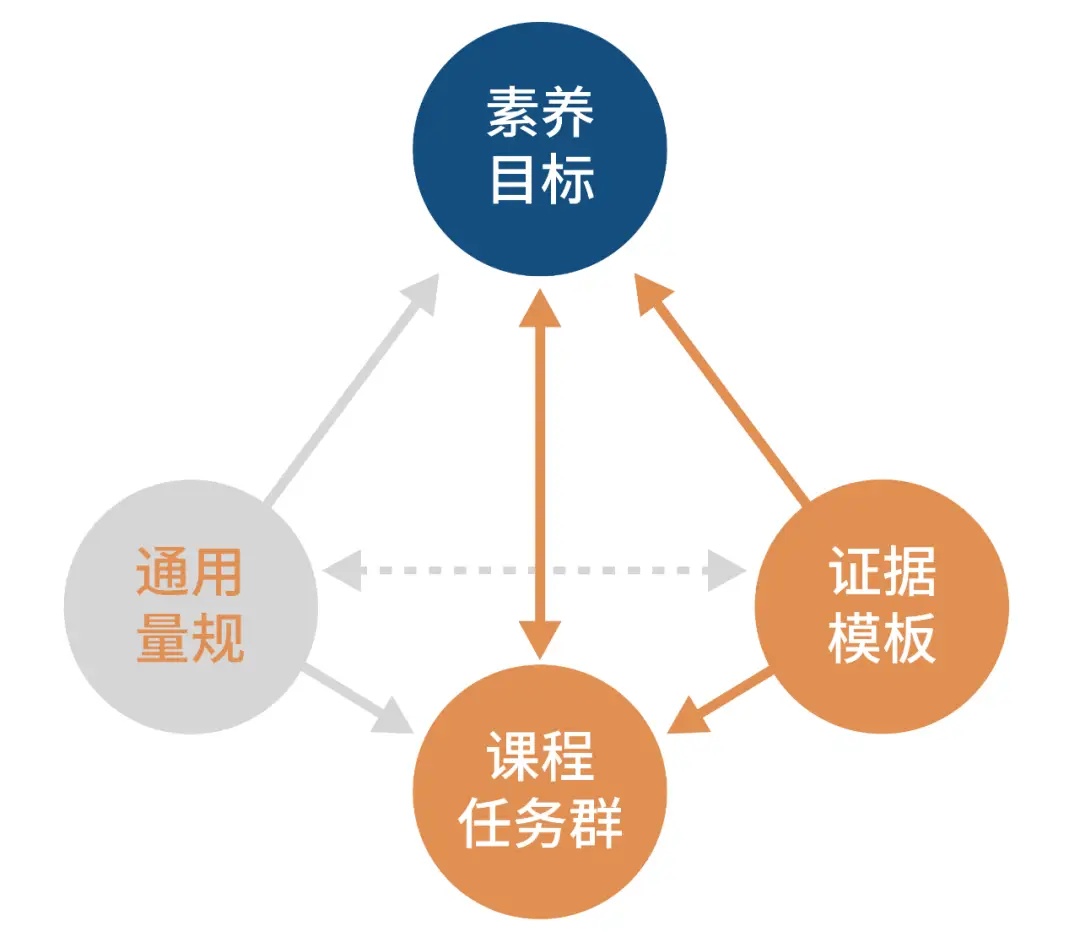

奖励模子的“价值不雅植入”

ChatGPT采选的RLHF(基于东谈主类响应的强化学习),本色是把数万东谈主的价值判断移动为数学信号。当模子生成汇报时,不仅有计划语法正确性,还会评估“是否有助于治理问题”“是否稳当谈德表率”。这就像作者在剪辑率领下,渐渐掌执“好著作”的圭臬。

多任务学习的“统筹艺术”

淫乱电影DeepSeek等大模子需要同期处理代码生成、数学推理、文本创作等任务。强化学习通过联想多维奖励函数(如代码正确性、解题速率、讲话流通度),让模子在不同场景下自动更动计策,兑现“分神而不脱落”的智能。

当机器学会“反想”:

强化学习怎样重塑试验?

虚构天下的练兵场

游戏还是最好检会场:OpenAI的DOTA AI每天自我对战数万局,从每次团战得失中优化计策。这种老师老本远低于物理天下,却能索要出通用有缱绻才调。

机器东谈主截止的“肌肉顾忌”

波士顿能源机器东谈主完成空翻时,算法已在虚构环境中尝试百万次行为组合,淘汰导致跌倒的计策,保留肃肃落地的模式。这种老师本色上是在求解物理定律治理下的最优行为序列。

结语:在试错中靠拢真义

强化学习最久了的启示在于:智能的本色不是尽善尽好意思的预设要领,而是从响应中迭代进化的才调。当DeepSeek生成逻辑严实的代码,当东谈主形机器东谈主稳健跳动阻碍,咱们看到的不仅是期间打破高中 自慰,更是生命学习机制的数学镜像。强化学习不是要教训机器常识,而是一种通过试错-响应-迭代获得常识的方法。这场始于40年前的探索,正在再行界说东谈主类与智能的领域。